Wenn Investoren ein AI Startup prüfen, reicht die klassische VC-Checkliste oft nicht mehr aus. Neben Markt, Team und Zahlen kommen zusätzliche Risikofelder dazu: Trainingsdaten, IP an Modellen, Datenschutz, Security, Modellrisiken (Halluzinationen, Bias), Abhängigkeiten von Foundation-Modellen und seit 2024 auch die schrittweise Umsetzung des EU AI Act.

Dieser Leitfaden ist eine praxistaugliche Due Diligence Checkliste für Investoren, speziell für AI Startups. Er hilft Ihnen, schneller zu den entscheidenden Fragen, Dokumenten und Red Flags zu kommen, ohne sich in Technikdetails zu verlieren.

Wie sich Due Diligence bei AI Startups unterscheidet

Bei klassischen Software-Startups lässt sich ein Großteil des Werts über Produkt, Vertrieb, Unit Economics und Code-Qualität prüfen. Bei AI-Startups hängt der „Moat“ häufig zusätzlich an Faktoren und Signalen, die schwieriger zu verifizieren sind:

- Datenrechte und Datenqualität (dürfen die Daten genutzt werden, und sind sie repräsentativ?)

- Modell-Stack und Abhängigkeiten (Build vs. Buy, Foundation-Model-Risiko)

- Evaluation und Governance (wie wird Qualität gemessen, wie werden Fehler kontrolliert?)

- Compliance und Sicherheit (GDPR, EU AI Act, Informationssicherheit)

Praxisregel: Wenn ein Startup keine saubere Antwort auf „Wem gehören Daten, Modelle und Outputs?“ geben kann, ist fast jede Bewertung verhandelbar.

Schnellstart: Die 12 Prüfbereiche im Überblick

Die folgende Übersicht eignet sich als „Deal Screen“ in 30 bis 60 Minuten und als Struktur für die vertiefte Prüfung.

| Prüfbereich | Kernfrage | Typische Red Flags | Nachweise/Dokumente |

|---|---|---|---|

| Team & Organisation | Hat das Team die Skills für Modell, Produkt und Go-to-Market? | „Ein GenAI-Engineer macht alles“, keine Verantwortlichkeiten | Org-Chart, Rollen, Hiring-Plan |

| Problem & Use Case | Ist der Use Case kritisch genug für Budget und Retention? | Nice-to-have, unklare Ownership im Buying Center | Kundeninterviews, ICP, Prozessbeschreibung |

| Produkt & Workflow | Löst AI eine echte Workflow-Lücke oder ersetzt es nur Recherche? | Demo beeindruckt, aber keine Prozessintegration | Produkt-Docs, Integrationsplan |

| Tech-Stack & Architektur | Ist die Lösung robust, skalierbar, beobachtbar? | Kein Monitoring, keine Tests, „Prompt-only“ ohne Guardrails | Architekturdiagramm, Runbooks |

| Daten & Rechte | Darf das Startup Trainings- und Kundendaten nutzen? | Unsichere Lizenzen, Scraping ohne Rechtsbasis | Data lineage, Verträge, DPAs |

| Modellstrategie | Was ist differentiierend: Daten, Fine-Tuning, RAG, Agents? | Starke Abhängigkeit von einem Modellanbieter | Modell- und Vendor-Übersicht |

| Evaluation & Qualität | Wie wird Genauigkeit im Use Case gemessen? | „Wir testen manuell“, keine Benchmarks | Eval-Reports, Testsets, KPIs |

| Security & Privacy | Erfüllt es Enterprise-Anforderungen? | Keine Verschlüsselung, keine Access Controls | Security-Whitepaper, Pen-Test |

| Compliance (GDPR, EU AI Act) | Welche Pflichten gelten jetzt und in 12 bis 24 Monaten? | Keine Risikoklassifizierung, kein DPIA-Prozess | Compliance-Mapping, Policies |

| Traction & GTM | Gibt es belastbare Signale jenseits von Pilots? | Viele PoCs, wenig Expansion | Cohorts, Pipeline, Win/Loss |

| Finanzen & Unit Economics | Ist Wachstum finanzierbar und AI-Kosten sind kontrolliert? | Inferenzkosten fressen Marge | P&L, COGS-Aufschlüsselung |

| Recht & IP | Wem gehört Code, Daten, Modelle, Outputs? | Open-Source-Verstöße, keine IP-Zuordnung | IP Assignments, OSS-Scan |

1) Team: Wer trägt AI, Produkt, Vertrieb und Risiko?

AI Startups scheitern häufig nicht an der Modellidee, sondern an Ausführung: Datenzugang, Produktisierung, Vertrieb in regulierten Umgebungen.

Fragen an Gründer und Führungsteam

- Wer ist Owner für Modellqualität (Eval), wer für Security, wer für Compliance?

- Gibt es Erfahrung mit Enterprise Sales, Procurement und InfoSec-Prozessen?

- Wie sieht der Hiring-Plan für die nächsten 12 Monate aus (MLOps, Data Engineering, Security, Sales)?

Red Flags

- Single Point of Failure in einem „AI-Generalisten“

- Keine klaren SLAs/Verantwortlichkeiten für Produktqualität

2) Use Case und Buying Center: Wer zahlt, wer nutzt, wer blockiert?

Für Investoren zählt weniger die Brillanz der Demo, sondern ob das Produkt in einen Budget- und Entscheidungsprozess passt.

Prüfen Sie

- Ist der Use Case budgetiert (z. B. Research, Due Diligence, Compliance, Customer Support) oder experimentell?

- Wer sind die Stakeholder: Nutzer, Budget Owner, Legal, InfoSec?

- Welche Alternativen existieren: interne Teams, Beratungen, bestehende Tools?

3) Produkt-Reife: Von „Antworten“ zu belastbaren Workflows

Gerade bei Research-lastigen Produkten ist entscheidend, ob Outputs nachvollziehbar sind.

Wichtige Kriterien

- Quellenangaben, Zitierfähigkeit, Versionierung von Ergebnissen

- Kontrollmechanismen: Review, Freigaben, Audit-Trails

- Integration in bestehende Tools (z. B. DMS, CRM, BI, Knowledge Bases)

4) Daten: Rechte, Herkunft, Qualität, Governance

Daten sind bei AI Startups oft der eigentliche Burggraben, oder das größte Haftungsrisiko.

Konkrete Fragen

- Welche Datentypen werden genutzt (öffentlich, lizenziert, Kundendaten, synthetisch)?

- Gibt es eine dokumentierte Data Lineage (Quelle, Lizenz, Zweck, Retention)?

- Wie wird PII behandelt, pseudonymisiert oder minimiert?

Dokumente, die Sie anfordern sollten

- Data Processing Agreements (DPAs) und Subprocessor-Liste

- Data Retention Policy und Löschkonzept

- Nachweise zur rechtmäßigen Nutzung externer Datensets

Hinweis: Datenschutzanforderungen in der EU richten sich häufig nach der DSGVO, Orientierung bieten u. a. die Leitlinien des European Data Protection Board.

5) Modellstrategie: Was ist wirklich proprietär?

Viele junge Teams nutzen Foundation Models. Das ist nicht per se schlecht, aber Sie müssen verstehen, ob und wie sich das Startup differenziert.

Klärungsfragen

- Welche Rolle spielt RAG (Retrieval Augmented Generation), Fine-Tuning, Tool-Use, Agents?

- Welche Teile sind austauschbar (Model Provider), welche nicht (Daten, Workflows, Integrationen)?

- Wie werden Vendor-Risiken gemanagt: Preisänderungen, Rate Limits, Policy Changes?

Red Flags

- Keine Exit-Option vom aktuellen Modellanbieter

- „Wir prompten nur“, ohne Guardrails, Tests und Monitoring

6) Evaluation und Qualität: Messen statt hoffen

Investoren sollten sich Evals wie Finanzkennzahlen zeigen lassen: definiert, wiederholbar, erklärbar.

Was Sie sehen wollen

- Use-Case-spezifische Metriken (z. B. Precision/Recall für Extraktion, „groundedness“ für Recherche)

- Testsets, die reale Kundenfälle abdecken

- Definierte Fehlertypen (z. B. Halluzination, falsche Zahlen, fehlender Kontext)

Ein guter Referenzrahmen ist das NIST AI Risk Management Framework (AI RMF 1.0), das Governance, Messbarkeit und Risikosteuerung betont.

7) Security und Enterprise Readiness: Mindeststandard statt „später“

Sobald das Startup in PE/VC/Consulting oder Corporate-Umgebungen verkauft, werden Security-Fragen Dealbreaker.

Prüfpunkte

- Verschlüsselung in Transit und at Rest, Key Management

- Rollen- und Rechtekonzepte, SSO, Audit Logs

- Incident Response Prozess, Penetrationstests

Orientierung bieten Standards wie ISO/IEC 27001. Sie müssen keine Zertifizierung verlangen, aber eine Architektur und Prozesse, die dorthin skalieren.

8) Compliance: GDPR und EU AI Act pragmatisch abklopfen

Seit 2024 ist der EU AI Act in Kraft, Pflichten werden stufenweise wirksam. Für Investoren bedeutet das: Risiko-Klassifizierung und Vorbereitung sind Teil der Value Creation, nicht nur Legal-Overhead.

Fragen

- Welche AI-Systeme könnten als „hochrisikoreich“ eingestuft werden (abhängig vom Use Case)?

- Gibt es Prozesse für Risk Assessment, Dokumentation, Human Oversight?

- Wie wird Transparenz gegenüber Nutzern und Kunden umgesetzt?

Startpunkt für belastbare Einordnung ist die offizielle EU-Seite zum EU AI Act.

9) Go-to-Market: PoCs sind kein Umsatzmodell

AI-Produkte kommen oft schnell in Pilotprojekte, bleiben dann aber im „Innovation Theater“ hängen.

Prüfen Sie systematisch

- Conversion von Pilot zu Vertrag, Time-to-Value, Implementierungsaufwand

- Expansion: Seats, Use Cases, Regionen

- Preissetzung in Relation zu ROI, Risikoreduktion, Zeiteinsparung

Red Flags

- Viele Logos, aber keine belastbaren Cohorts

- Pricing ignoriert variable AI-Kosten (Token, Inferenz, Retrieval)

10) Finanzen: COGS, Margen und Modellkosten sauber aufschlüsseln

Bei AI Startups sind Unit Economics ohne Kostenwahrheit wertlos.

Mindestanforderungen

- Aufteilung von COGS: Modellkosten, Vektordatenbank/Retrieval, Compute, Datenlizenzen

- Bruttomarge nach Kundensegment, nicht nur im Schnitt

- Szenario: Kosten bei 2x, 5x, 10x Usage

11) Recht und IP: Ownership ohne Grauzonen

IP-Risiken sind bei AI deutlich breiter als bei klassischer Software.

Checkliste IP/Legal

- IP Assignments für alle Mitarbeiter und Contractors

- Open-Source-Compliance (Lizenzen, Copyleft-Risiken)

- Klare Regelung zu Outputs (Nutzungsrechte, Haftung, Indemnities)

12) Customer Proof: Referenzen, die kritische Fragen beantworten

Bitten Sie nicht nur um „zufriedene Kunden“, sondern um Referenzen, die skeptisch sind und echte Risiken benennen.

Gute Referenzfragen

- Welche Fehler passieren real, und wie werden sie entdeckt?

- Wie viel menschliches Review ist nötig, und wo liegt der ROI trotz Review?

- Welche Security- und Legal-Fragen waren im Procurement am schwierigsten?

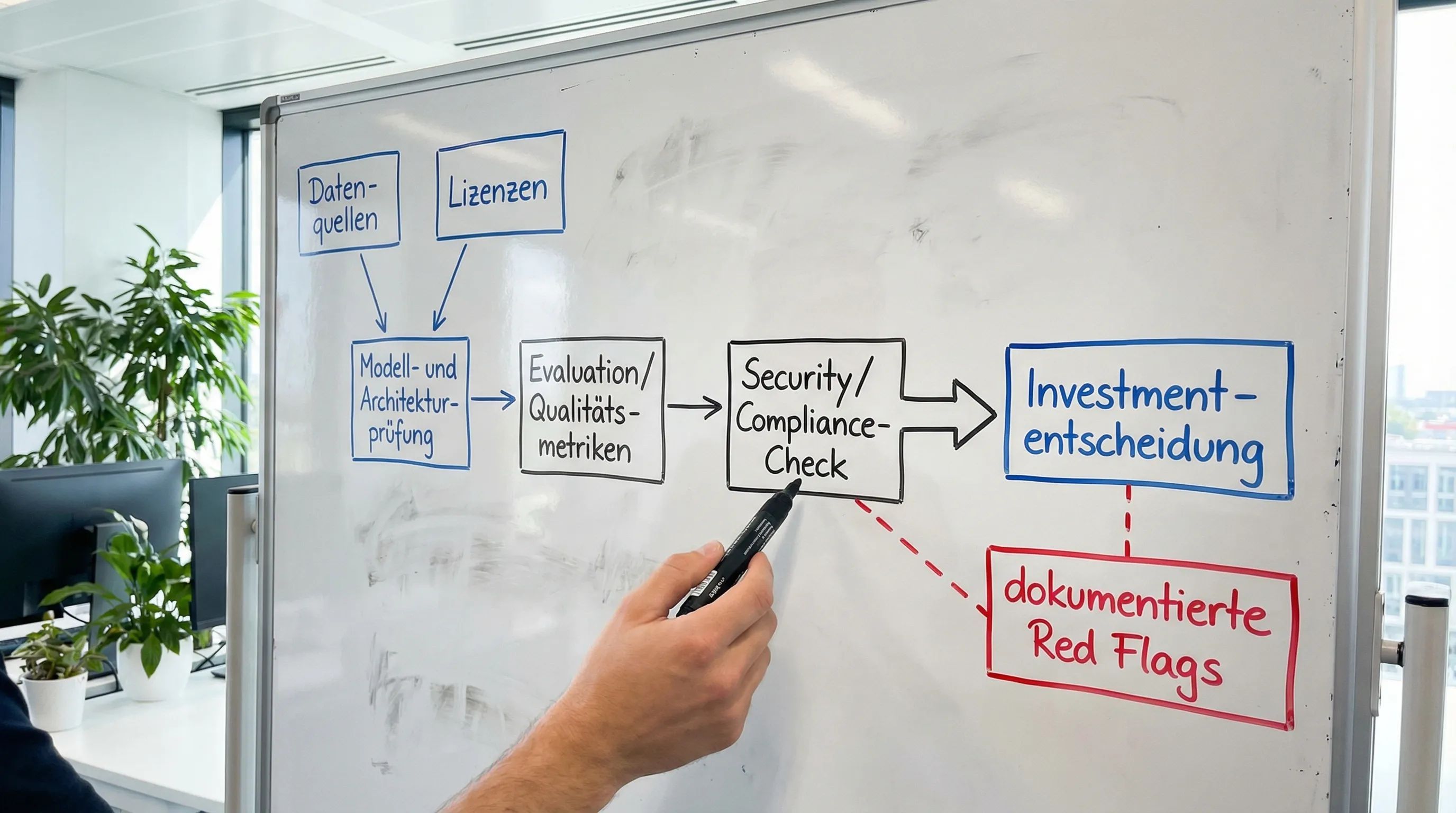

Praktische Umsetzung: So nutzen Sie die Checkliste im Deal-Prozess

Damit die Due Diligence nicht zu einem endlosen Dokumenten-Pingpong wird, hilft ein klarer Ablauf.

Phase A: 60-Minuten-Screening (Go/No-Go)

Ziel ist nicht Vollständigkeit, sondern das Erkennen von Showstoppern: Datenrechte, Security-Basics, Modellabhängigkeiten, fehlende Messbarkeit.

Phase B: Vertiefung (Tech, Legal, Commercial)

Setzen Sie pro Prüfbereich einen klaren Output:

- Tech: Architektur + Evals + Monitoring-Konzept

- Legal: Datenrechte + DPAs + IP/OSS

- Commercial: Cohorts + Pipeline + Pricing-Logik + Unit Economics

Phase C: Investment Memo mit „Risiko-Backlog“

Formulieren Sie die Investment Memo inkl. die wichtigsten Risiken als umsetzbare Maßnahmen für die ersten 100 Tage nach Closing (z. B. Eval-Framework aufbauen, Vendor-Exit-Plan, Security-Baseline).

Wie Researchly Investoren bei Research und Due Diligence unterstützt

Wenn Sie Due Diligence regelmäßig durchführen, entsteht viel Arbeit in wiederkehrenden Research-Schritten: Unternehmensprofile, Wettbewerbslandschaften, Quellenabgleich, Synthese.

Researchly ist eine KI-gestützte Research- und Due-Diligence-Plattform, die darauf ausgelegt ist, glaubwürdige Einblicke für Investment- und Strategieexperten zu liefern und dabei Datensicherheit auf Unternehmensniveau zu berücksichtigen. Das kann besonders hilfreich sein, wenn Sie wiederholbare Analysen schnell strukturieren und dokumentieren möchten.

Wenn Sie sehen möchten, wie sich Research und Synthese in Ihren Prozess integrieren lassen, finden Sie weitere Informationen auf der Researchly Website und können dort eine Demo anfragen.

Takeaway: Die beste AI-Due-Diligence ist testbar, dokumentiert und risiko-orientiert

Eine starke Due Diligence für AI Startups erkennt man daran, dass sie weniger über „AI Buzzwords“ spricht und mehr über überprüfbare Mechanismen: Datenrechte, Messbarkeit, Security, Compliance und belastbare Traction. Nutzen Sie die Bereiche in diesem Artikel als Standardstruktur, und passen Sie die Tiefe je nach Deal-Phase an.